Apple 将 iPhone 儿童安全功能扩展到英国

自 8 月份首次宣布这一消息以来,以及对尚未发布的组件引起了相当大的争议之后,苹果公司正在将一项旨在保护儿童免遭发送或接收色情内容的 iPhone 功能扩展到英国。

消息中的通信安全最终作为 12 月 iOS 15.2 点更新的一部分推出。然而,到目前为止,这仅限于美国。 《卫报》 爆料称,苹果公司宣布计划将此功能引入英国,但具体时间尚不清楚。

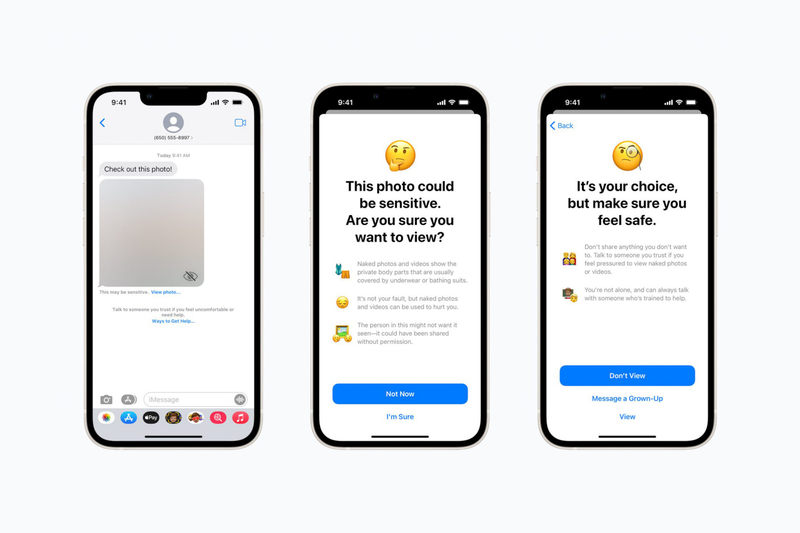

在儿童设备上启用该功能后,该功能会使用设备上的 AI 工具来扫描通过”消息”收到的所有照片中是否存在裸露内容。如果被发现,图像将变得模糊,用户将收到一条警告,指出它可能包含敏感内容以及有用资源的链接。同样,该工具会扫描儿童发送的照片,如果检测到任何裸体,建议他们不要发送材料,并联系成年人。

“消息分析图像附件并确定照片是否包含裸体,同时保持消息的端到端加密,”Apple 解释。 “该功能的设计使得设备不会检测到裸体。 Apple 无法访问这些消息,也不会向家长或其他任何人发送任何通知。”

该功能在最初的计划中已经被淡化,这反映了苹果公司受到隐私团体的抵制。在最初的构想中,该功能包括一个家长选项,如果在 13 岁以下儿童发送或接收的图像中检测到裸体,则自动通知家长。在担心家长暴力或虐待的风险后,苹果删除了这一功能。现在,该功能使孩子们能够向值得信赖的成年人发送消息(如果他们选择),与查看图像的决定分开,并且除非孩子选择,否则不会通知父母。

大量儿童安全功能 – 其中还包括一个有争议的人工智能工具,可以使用哈希值扫描上传到 iCloud 的照片,并将其与已知儿童的数据库进行比较性虐待材料——最初计划作为去年 iOS 15 软件更新的一部分出现。 Apple 去年年底推迟了 CSAM 组件,至今尚未实施。

这对我意味着什么?

美国读者不会受到此消息的影响,因为该功能自 iOS 15.2 起就已启用。如果消息中的通信安全正在扩展到第二个国家,我们可以推断苹果公司对结果感到放心,并且不太可能在美国回溯并删除它。此功能仅影响”消息”中收到的图像,不会扫描存储在您孩子的照片库中的任何照片。

有孩子的英国读者很快将可以选择(默认情况下禁用)在孩子的手机上启用该功能,从而激活设备上扫描潜在的色情内容。但正如我们上面所解释的,这些扫描的结果不会自动与家长共享,但如果您打算启用该功能,明智的做法是将其纳入有关数字共享的注意事项的更广泛讨论的一部分.