Apple CSAM 检测:删除有争议的照片扫描功能

2021 年底,Apple 宣布多项与儿童性虐待材料 (CSAM) 相关的新功能。其中一些受到了严格的审查并引起了一些愤怒,包括苹果员工的愤怒。以下是您需要了解的有关 新 技术,然后在今年晚些时候推出。

Apple 和 CSAM 扫描:最新消息

十二月2022 年 8 月:苹果决定取消有争议的照片扫描功能。

四月2022 年 2 月 21 日:消息的对话安全功能即将登陆英国,但具体时间表尚未确定宣布。

十二月2021 年 1 月 15 日:Apple 从其网站中删除了对 CSAM 系统的引用。 Apple 表示 CSAM 功能仍然”延迟”并且未取消。

十二月2021 年 1 月 14 日: Apple 发布了对话官方 iOS 15.2 更新中的消息安全功能。 CSAM功能尚未发布。

十一月2021 年 10 月:iOS 15.2 beta 2 具有争议较少的消息对话安全功能。它依赖于图像的设备上扫描,但它不会将图像与已知数据库进行匹配,并且除非父帐户启用它,否则不会启用它。这与CSAM不同。 获取详细信息。

九月2021 年 1 月 3 日: Apple 宣布将推迟发布其 CSAM 功能 在 iOS 15、iPadOS 15、watchOS 8 和 macOS 12 Monterey 中,直到今年晚些时候。这些功能将成为操作系统更新的一部分。

八月2021 年 2 月 24 日: Apple 已向 9to5Mac 确认 已经使用图像匹配技术扫描 iCloud 电子邮件中的 CSAM。

八月2021 年 10 月 19 日:近 100 个政策和权利群组发表了一封公开信敦促苹果放弃在 iOS 15 中实施该系统的计划。

八月2021 年 12 月 18 日:有报道称 Apple CSAM 技术所基于的 NeuralHash 系统遭到欺骗,Apple 表示该系统“行为如所描述。”

八月2021 年 12 月 13 日:在接受《华尔街日报》乔安娜·斯特恩 (Joanna Stern) 采访时,软件工程高级副总裁克雷格·费德里吉 (Craig Federighi) 表示,苹果的新技术”被广泛误解”。他进一步解释了该系统的工作原理,如下所述。 Apple 还发布了一份文档,其中包含有关 Messages 中的安全功能和 CSAM 检测功能的更多详细信息。

基础知识

Apple 正在推出哪些技术?

Apple 将在三个领域推出新的反 CSAM 功能:消息、iCloud 照片以及 Siri 和搜索。根据苹果公司的说法,以下是它们的实施方式。

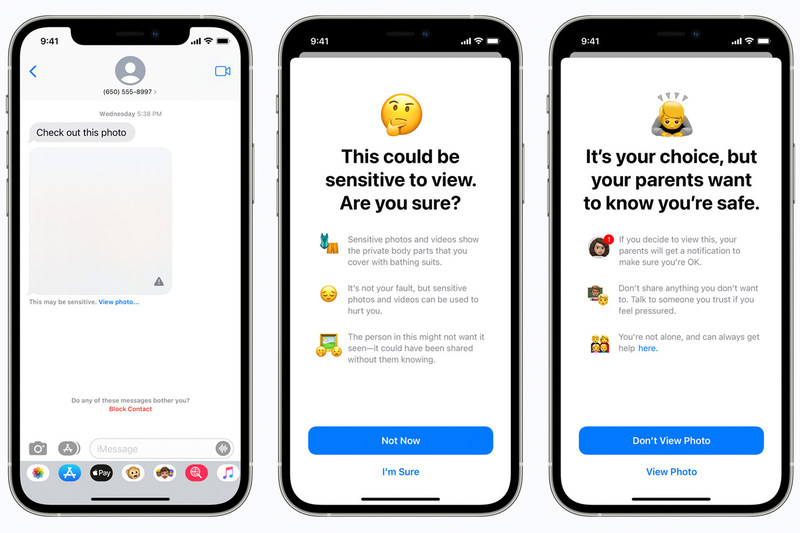

消息:消息应用将使用设备上的机器学习来警告儿童和家长有关敏感内容的信息。

iCloud 照片:在将图像存储到 iCloud 照片中之前,会根据已知的 CSAM 哈希值对该图像执行设备上匹配过程。 Apple 已决定不会在设备上提供此功能。

Siri 和搜索:Siri 和搜索将提供额外资源,帮助儿童和家长确保上网安全,并在不安全情况下获得帮助。

系统什么时候到达?

苹果在 9 月初宣布,该系统将不会在秋季发布的 iOS 15、iPadOS 15、watchOS 8 和 macOS 12 Monterey 中提供。这些功能将在今年晚些时候的操作系统更新中提供。

新的 CSAM 检测工具将于今年晚些时候随新操作系统一起推出。

苹果

为什么系统现在发布?

在接受《华尔街日报》乔安娜·斯特恩 (Joanna Stern) 采访时,克雷格·费德里吉 (Craig Federighi) 表示,之所以在 iOS 15 中发布该功能,是因为”我们已经弄清楚了。”

CSAM 扫描

扫描技术是否意味着 Apple 能够看到我的照片?

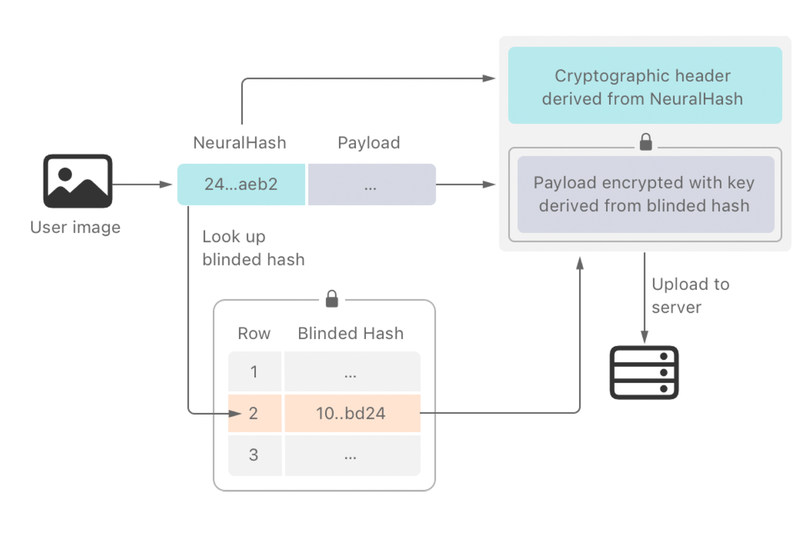

不完全是。 Apple 是这样解释这项技术的:系统不是在云端扫描图像,而是使用 国家失踪中心和受剥削儿童 (NCMEC) 以及其他儿童安全组织。苹果进一步将该数据库转换为一组不可读的哈希值,安全地存储在用户的设备上。正如苹果公司所解释的那样,该系统正在严格寻找”特定的、已知的”图像。 Apple 员工只会看到标记为具有哈希值的照片,即使如此,也只有在满足阈值时才会看到。

但是 Apple 正在扫描我设备上的照片,对吧?

是和否。该系统是多方面的。其一,苹果表示该系统不适用于禁用了 iCloud Photos 的用户,不过目前尚不清楚该扫描是否仅对上传到 iCloud Photos 的图像执行,或者所有图像都会被扫描和比较,但扫描结果(哈希匹配与否)仅在上传到 iCloud 照片时与照片一起发送。 Federighi 表示,”算法的另一半是由云完成的”,因此当在设备上扫描照片时,需要 iCloud 才能完全工作。 Federighi 强调该系统”实际上是在 iCloud 中存储图像的管道的一部分。”

如果系统检测到 CSAM 图像会发生什么?

由于系统仅适用于 NCMEC 提供的 CSAM 图像哈希,因此它只会报告 iCloud 照片中已知 CSAM 的照片。如果确实检测到 CSAM 超过某个阈值(Federighi 表示”大约为 30″),Apple 将进行人工审查,然后决定是否向 NCMEC 报告。苹果表示,虽然会向有关当局报告任何情况,但不会自动向执法部门报告。

系统是否会将我孩子的真实照片误认为是 CSAM?

这是极不可能的。由于该系统仅扫描已知图像,苹果表示该系统错误标记任何给定帐户的可能性每年低于万亿分之一。如果确实发生了这种情况,人工审查会在升级到当局之前发现它。此外,对于任何认为自己的帐户被错误标记和禁用的人,我们都设有申诉流程。

然而,八月份的一份报告似乎证明了该系统是容易出错的。 GitHub 用户 AsuharietYgva 据报道概述了苹果在用户 dxoigmn 似乎声称有 使用创建相同哈希的两张不同图像来欺骗系统。作为回应,苹果为该系统进行了辩护,并告诉 Motherboard,使用的系统”是通用版本,而不是用于 iCloud Photos CSAM 检测的最终版本”。在 分析安全威胁的文档,苹果表示,”NeuralHash 算法 […] 包含在代码中签名的操作系统[和]安全研究人员可以验证其行为是否符合描述。”

我可以选择退出 iCloud 照片 CSAM 扫描吗?

不可以,但您可以禁用 iCloud 照片以阻止该功能运行。目前尚不清楚这样做是否会完全关闭苹果设备上的照片扫描,但只有当图像上传到 iCloud Photos 时,苹果才会收到这些扫描的结果(是否匹配哈希值)。

苹果

消息

Apple 也会扫描我在”信息”中的所有照片吗?

不完全是。 Apple 在”信息”中的安全措施旨在保护儿童,并且仅适用于在 iCloud 中设置为家庭的儿童帐户。

那么它是如何工作的呢?

消息中的通信安全与 iCloud 照片的 CSAM 扫描完全不同。它不是使用图像哈希值与已知的儿童性虐待图像进行比较,而是使用机器学习算法分析消息发送或接收的图像,以找出任何露骨的性内容。图像不会与 Apple 或任何其他机构(包括 NCMEC)共享。家长可以在儿童帐户上启用该系统,以便在他们(和孩子)即将接收或发送露骨色情材料时向他们(和孩子)发出警告。

家长可以选择退出吗?

家长需要在为孩子设置的帐户上专门启用新的消息图像扫描功能,并且可以随时将其关闭。

iMessage 仍会进行端到端加密吗?

是的。苹果表示,消息中的通信安全不会改变消息中包含的隐私功能,并且苹果永远不会获得通信权限。此外,Apple 无法获得任何通信、图像评估、干预或通知。

如果发现露骨色情图片会怎样?

当家长为孩子的帐户启用此功能并且孩子发送或接收露骨色情图片时,照片将变得模糊,并且孩子将收到警告,向其展示资源,并保证如果他们不想要也没关系查看或发送照片。对于 12 岁及以下儿童的帐户,家长可以设置家长通知,如果孩子确认并发送或查看已确定为露骨色情的图像,就会发送家长通知。

Siri 和搜索

Siri 和搜索有哪些新功能?

Apple 正在增强 Siri 和搜索,以帮助人们找到报告 CSAM 的资源,并通过提供额外的资源来帮助儿童和家长保持上网安全并在不安全情况下获得帮助,从而扩展 Siri 和搜索中的指导。 Apple 还更新了 Siri 和搜索,以便在用户搜索与 CSAM 相关的查询时进行干预。苹果表示,干预措施将包括向用户解释对这个主题的兴趣是有害的和有问题的,并向合作伙伴提供资源以获得解决此问题的帮助。

争议

那么为什么人们会感到不安?

虽然大多数人都认为苹果系统的范围受到适当限制,但专家、监管机构和隐私倡导者担心滥用的可能性。例如,爱德华·斯诺登(Edward Snowden)揭露了美国国家安全局的全球监视计划,目前正在流亡,tweet “无论意图多么善意,苹果正在推出大规模监控以此向全世界传达。不要误会:如果他们今天可以扫描儿童色情内容,那么明天他们就可以扫描任何内容。”此外,电子前沿基金会批评了该系统,约翰霍普金斯大学密码学教授 Matthew Green 解释了苹果正在使用的系统可能被滥用的可能性.

许多人指出,这些扫描技术是有效的(有些有限的)大规模监视工具。与专制政权所使用的工具没有什么不同——只是转向了不同的目的。

——Matthew Green (@matthew_d_green) 2021 年 8 月 5 日

人们还担心,苹果通过使用 iPhone 扫描 CSAM 图像来牺牲 iPhone 内置的隐私功能。虽然许多其他服务都会扫描 CSAM 图像,但 Apple 的系统的独特之处在于它使用设备上匹配而不是上传到云端的图像。

CSAM系统可以用于扫描其他图像类型吗?

目前还没有。苹果表示,该系统仅设计用于扫描 CSAM 图像。然而,苹果理论上可以扩充哈希列表来查找与其他事物相关的已知图像,例如 LGBTQ+ 内容,但苹果一再表示该系统仅针对 CSAM 设计。

Apple 是否扫描任何其他应用或服务?

Apple 最近证实,它一直在其服务器上使用图像匹配技术扫描 iCloud 电子邮件。然而,它坚称 iCloud 备份和照片不是该系统的一部分。值得注意的是,iCloud 电子邮件在 Apple 的服务器上并未加密,因此扫描图像是一个更简单的过程。

如果政府强迫 Apple 扫描其他图像怎么办?

苹果表示将拒绝此类要求。

苹果

其他公司是否扫描 CSAM 图像?

是的,大多数云服务,包括 Dropbox、Google 和 Microsoft,以及Facebook 也有检测 CSAM 图像的系统。这些都是通过解密云中的图像来扫描它们来操作的。

消息技术会出错吗?

费德里吉表示,该系统”很难”被愚弄。然而,虽然他表示苹果”很难”想出图像来欺骗消息系统,但他承认这并不是万无一失的。

Apple 是否会被阻止实施其 CSAM 检测系统?

这很难说,但新技术实施之前和之后很可能都会发生法律纠纷。 8 月 19 日,超过 90 个政策和权利团体 发表了一封公开信,敦促苹果放弃该系统:”虽然这些功能旨在保护儿童并减少儿童性虐待材料的传播,但我们担心它们会被用来审查受保护的言论,威胁世界各地人们的隐私和安全,并给许多儿童带来灾难性后果,”信中说。