iPhone 的底座上有一条小裂缝。它会变得多大?

苹果公司上周突然宣布将在 iOS 中添加一系列涉及儿童性虐待材料 (CSAM) 的功能,这引起了完全可以预见的反应。或者,更准确地说,是反应。执法方面的人士赞扬了苹果公司的工作,而公民自由方面的人士则指责苹果公司将 iPhone 变成了监控设备。

苹果的声明会受到严格审查并不奇怪。如果说整个故事有什么令人惊讶的话,那就是苹果似乎并没有预料到其公告所受到的所有阻力。该公司必须发布常见问题解答文件作为回应。如果您的公告发布后出现了 FA,那么您的公告可能搞砸了。

这样的公告值得仔细审查。对于那些试图放弃对这个问题的激烈看法的人来说,问题在于它极其复杂,而且没有简单的答案。这并不意味着苹果的做法从根本上是正确或错误的,但这确实意味着苹果做出了一些值得探索和争论的选择。

苹果的妥协

我不太清楚苹果为什么选择这个时候推出这项技术。苹果公司的隐私主管暗示,它是 因为它已经准备好了,但这有点回避——苹果必须选择优先考虑哪些技术,并且它优先考虑了这项技术。 Apple 可能预计法律会要求其扫描 CSAM。苹果可能正在致力于增强 iCloud 的安全功能,因此需要采用这种方法。也有可能 Apple 刚刚决定需要采取更多措施来阻止 CSAM 的分发。

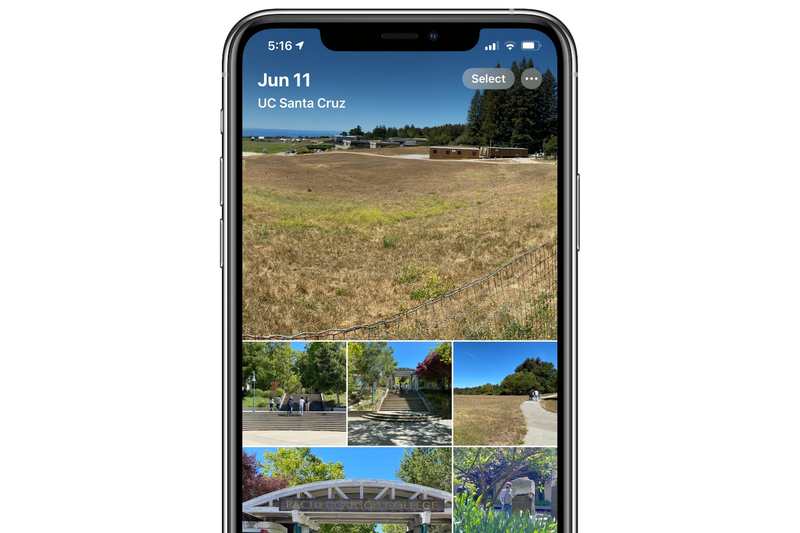

关于苹果动机的最大线索是该功能实现的非常具体的方式。我将不再为您提供冗长的解释,但简而言之:Apple正在将图像与 国家失踪和受虐儿童中心。它正在扫描将与 iCloud 照片同步的新图像。它不会扫描您设备上的所有照片,Apple 也不会扫描存储在 iCloud 服务器上的所有照片。

简而言之,Apple 构建了一个 CSAM 检测器,位于您的设备和 iCloud 之间的门口。如果您不与 iCloud 同步照片,则检测器永远不会运行。

CSAM 检查是针对上传到 iCloud 的图像进行的,而不是针对 iPhone 的照片库中的图像。

这一切让我相信还有另一件事要做,它将使苹果能够使其云服务更加安全和私密。如果这个扫描系统本质上是一种权衡,可以让 Apple 为其用户提供更多隐私,同时又不放弃防止 CSAM 传播的道德义务,那就太好了。但在苹果公司发布这样的公告之前,我们无法得知具体情况。与此同时,所有这些潜在的隐私收益都是理论上的。

间谍在哪里?

近年来,苹果公司明确表示,它认为在我们的设备上进行的用户数据分析从根本上来说比在云中运行的分析更加私密。在云中,您的数据必须经过解密才能进行分析,从而可以进行几乎任何形式的分析。任何具有适当访问级别的员工也可以轻松浏览您的数据。但是,如果所有分析都发生在您的设备上(这就是为什么 Apple 的现代芯片拥有强大的神经引擎组件来完成这项工作),那么数据就永远不会离开家。

苹果在这里的做法让所有这些都受到了质疑,我怀疑这就是对此公告一些最大批评的根源。苹果正在做出它认为会增强隐私的决定。 Apple 没有人会扫描您的照片,Apple 甚至没有人可以查看潜在的 CSAM 图像,直到超过阈值以减少误报的可能性。只有您的设备才能看到您的数据。这很棒,因为我们的设备是神圣的,它们属于我们。

除了……现在我们的设备上将运行一种算法,旨在观察我们的数据,如果它发现它不喜欢的东西,它就会连接到互联网并将该数据报告给Apple 。虽然如今它是专门为 CSAM 构建的,并且只需关闭 iCloud 照片库同步即可将其停用,但它仍然感觉像是越界了。我们的设备不仅会为我们工作,还会监视我们是否存在非法活动迹象并向当局发出警报。

苹果在这里面临的风险是巨大的。它投入了大量时间将设备上的操作与隐私等同起来,并且它有可能毒害所有这些工作,让人们认为我们的手机不再是我们的城堡。

重要的不是工具,而是它的使用方式

从很多方面来说,这是这个时代科技行业面临的最大挑战的另一个方面。技术变得如此重要和强大,每一项新的发展都会对全社会产生巨大的影响。

通过设备上的 CSAM 扫描仪,Apple 构建了一个经过精心校准的工具来保护用户隐私。如果构建此工具使 Apple 最终能够提供更广泛的 iCloud 数据加密,那么它甚至可能会净增加用户隐私。

但是工具没有好坏之分。 Apple 出于良好的目的构建了这个工具,但每次构建新工具时,我们所有人都需要想象它可能会如何被滥用。苹果似乎非常仔细地设计了此功能,以使其更难以被颠覆,但这并不总是足够的。

想象一下这样一个案例:外国的执法机构来到苹果公司,并表示他们已经编制了非法图像数据库,并希望将其添加到苹果公司的扫描仪中。苹果公司直言不讳地表示,它将拒绝所有此类请求。这是令人鼓舞的,而且我毫不怀疑,如果苹果试图采取这种策略,他们将放弃大多数国家。

但它能对中国说不吗?如果相关图像涉及恐怖组织成员,它能对美国政府说”不”吗?在一两年内,这样的政策会变得如此普遍,以至于当政府要求苹果或其同类公司开始扫描非法或颠覆性材料时,有人会注意到吗?这项技术的第一个实施是为了阻止 CSAM,没有人会反对尝试阻止对儿童的剥削。但还会有第二次实施吗?第三个?

如果中国要求苹果扫描仪添加图像,苹果能拒绝吗? Franck/Unsplash

如果中国要求苹果扫描仪添加图像,苹果能拒绝吗? Franck/Unsplash

Apple 已尽力在侵犯用户隐私和停止分发 CSAM 之间找到折衷方案。该功能的具体实现方式证明了这一点。 (坦率地说,任何试图向您推销苹果如何只是想监视您的简化故事的人都不值得听。)

但是,仅仅因为苹果公司已经完成了尽职调查并做出了一些谨慎的选择,以实施一种工具来阻止令人发指的材料的传播,并不意味着它就摆脱了困境。让我们的手机运行一种不是为了服务我们而是为了监视我们的算法,这就已经越界了。或许,跨越这条线是不可避免的。也许技术不可避免地将我们带入一个我们所说、所做和所见的一切都被机器学习算法扫描的世界,而机器学习算法的善意或恶意将取决于实施该算法的社会。

即使苹果的心是对的,我对它的理念能够承受执法机构和威权政府未来愿望的信心也没有我希望的那么高。我们都可以反对 CSAM,并钦佩苹果试图平衡这两种相互冲突的需求的聪明方式,同时仍然担心它对未来意味着什么。