苹果推迟了备受争议的 iCloud 照片 CSAM 扫描

苹果公司周五宣布,其透露的阻止儿童性虐待材料(CSAM)传播的三项功能将不会在秋季发布的 iOS 15、iPadOS 15、watchOS 8 和 macOS 12 Monterey 中提供。该公司将在”今年晚些时候的更新中”提供 CSAM 功能。

苹果公司周五宣布,其透露的阻止儿童性虐待材料(CSAM)传播的三项功能将不会在秋季发布的 iOS 15、iPadOS 15、watchOS 8 和 macOS 12 Monterey 中提供。该公司将在”今年晚些时候的更新中”提供 CSAM 功能。

在新闻稿中,Apple 表示”该计划雄心勃勃,保护儿童是一项重要责任。这些努力将随着时间的推移而发展和扩大。”

Apple 在 8 月初公布了 CSAM 功能,虽然科技界的许多人对 Apple 保护儿童的努力表示赞赏,但许多人也对 CSAM 功能背后的技术可能用于其他监视目的的可能性表示担忧。超过 90 个政策和权利组发表了一封公开信敦促苹果取消其 CSAM 功能。

引发争议的主要功能是 CSAM 检测功能,该功能会扫描设备上的图像以查找哈希值,然后在已知 CSAM 哈希值列表中检查这些哈希值。反对此功能的论点是它可以用于其他用途。例如,政府可以要求苹果创建类似的流程来检查被认为对政府政策具有决定性作用的图像。

苹果公司表示,在这种情况下,它会拒绝这样的要求,但该声明并没有让有关方面产生任何信心。政府总是可以(并且将会)因不遵守命令而造成后果,这可能会导致苹果改变其政策。 Apple 也有可能决定将该技术用于 CSAM 之外的自身目的,尽管这样做会削弱 Apple 作为一家关注用户隐私的公司的形象。

另外两个被延迟的 CSAM 功能是:

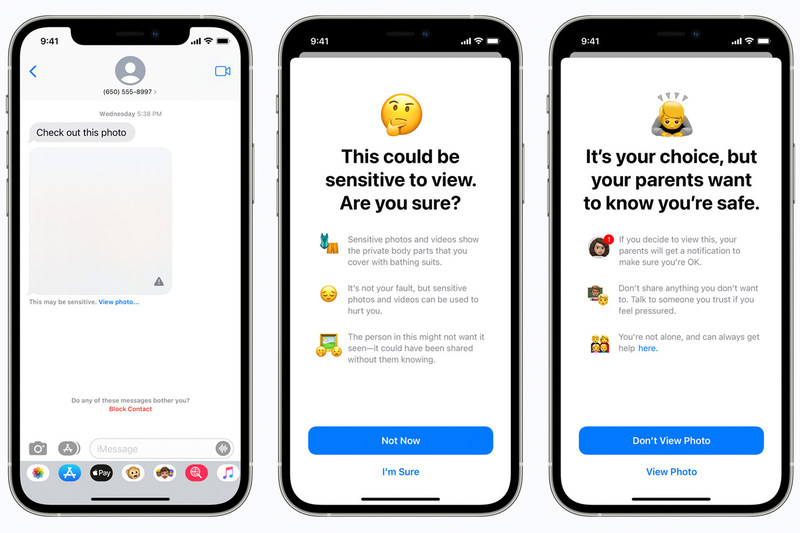

- 消息通信安全:消息应用将使用设备上的机器学习来警告儿童和家长注意敏感内容。

- Siri 和搜索:这些功能将提供额外的资源,帮助儿童和家长确保上网安全,并在出现不安全情况时获得帮助。

我们的CSAM 检测常见问题解答提供了有关这些内容的更多信息功能,包括对其工作原理和引起的争议的解释。